Google PageRank : Différence entre versions

(→Historique) |

(→Pérennité) |

||

| Ligne 61 : | Ligne 61 : | ||

==[[Pérennité du document|Pérennité]]== | ==[[Pérennité du document|Pérennité]]== | ||

| − | Parmi la myriade de pages sur le web, un bon nombre n’est plus [[Pérennité du document|compatible]]<ref>BOULÉTREAU, Viviane et Benoît HABERT, « Les formats », Pratiques de l’édition numérique, sous la direction de Michael E. Sinatra et Marcello Vitali-Rosati, Montréal: Les Presses de l’Université de Montréal, 2014, Parcours Numériques, p. 145–159, [Disponible en ligne: http://www.parcoursnumeriques-pum.ca/Les-formats http://www.parcoursnumeriques-pum.ca/Les-formats].</ref> avec l’algorithme de Google. PageRank filtre le web et ignore de façon sélective les pages qui ne sont pas plus compatibles avec les pratiques modernes du web. Certes, Google a dû intervenir plusieurs fois afin de rétablir l’ordre suite à un bon nombre de pratiques cherchant à manipuler l’algorithme. Parmi ces itérations, Google Hummingbird mise en ligne en 2013 prend en considération le sens de chaque mot dans la requête afin d’en comprendre le sens. C’est le sense de la requête, prise en entier, qui est priorisé à l’inverse des mots. En 2012, la mise à jour Pirate limite les pages qui contiennent un contenu en conflit avec les nomes DMCA. À chaque itération de l’algorithme, un nombre considérable de pages web peuvent perdre leur rang et d’autres peuvent même être ignorés de façon permanente. La longévité d’une page web est donc étroitement liée au moteur de recherche et il revient à l’éditeur numérique de rétablir la page ou de la laisser périr. À l’inverse du texte papier, un nombre considérable d’écritures numériques disparaît suite aux changements apportés à l’algorithme et souligne la fragilité du format numérique. | + | Parmi la myriade de pages sur le web, un bon nombre n’est plus [[Pérennité du document|compatible]]<ref>BOULÉTREAU, Viviane et Benoît HABERT, « Les formats », Pratiques de l’édition numérique, sous la direction de Michael E. Sinatra et Marcello Vitali-Rosati, Montréal: Les Presses de l’Université de Montréal, 2014, Parcours Numériques, p. 145–159, [Disponible en ligne: http://www.parcoursnumeriques-pum.ca/Les-formats http://www.parcoursnumeriques-pum.ca/Les-formats].</ref> avec l’algorithme de Google. PageRank filtre le web et ignore de façon sélective les pages qui ne sont pas plus compatibles avec les pratiques modernes du web. Certes, Google a dû intervenir plusieurs fois afin de rétablir l’ordre suite à un bon nombre de pratiques cherchant à manipuler l’algorithme. Parmi ces itérations, Google Hummingbird<ref>https://searchengineland.com/library/google/hummingbird-google</ref> mise en ligne en 2013 prend en considération le sens de chaque mot dans la requête afin d’en comprendre le sens. C’est le sense de la requête, prise en entier, qui est priorisé à l’inverse des mots. En 2012, la mise à jour Pirate<ref>https://searchengineland.com/library/google/google-pirate-update</ref> limite les pages qui contiennent un contenu en conflit avec les nomes DMCA. À chaque itération de l’algorithme, un nombre considérable de pages web peuvent perdre leur rang et d’autres peuvent même être ignorés de façon permanente. La longévité d’une page web est donc étroitement liée au moteur de recherche et il revient à l’éditeur numérique de rétablir la page ou de la laisser périr. À l’inverse du texte papier, un nombre considérable d’écritures numériques disparaît suite aux changements apportés à l’algorithme et souligne la fragilité du format numérique. |

=Conclusion= | =Conclusion= | ||

Version du 22 décembre 2017 à 07:55

Sommaire

[masquer]Google PageRank

L'organisation du Web dépend des hyperliens

Google est une force de Légitimation et influence la lecture/écriture

Historique

L’algorithme PageRank de Google a été créé par Larry Page en 1996[1]. L'algorithme est une partie intégrale du moteur de recherche Google que nous connaissons tous. Afin de comprendre l’objectif du moteur de recherche, il faut souligner les lacunes du moment. L’internet en est à ses débuts et une recherche sur le web est a plus à voir avec la loterie. Les premiers moteurs de recherche fonctionnaient par mots clés et le nombre de mots clés dans une page. Google a cherché à établir un ordre sur le web. Une classification automatique des pages disponibles afin d’être présenté à l’utilisateur lors d’une recherche. Le web est un espace en croissance et Google peut suivre cette croissance tout en offrant des résultats pertinents. En 2009, Google devient le moteur de recherche le plus utilisé en Amérique avec 64%[2] des parts du marché et 92% des internautes se servent de Google. Ce succès est lié à deux approches. Il utilise la structure du web et des liens afin de calculer la pertinence d’une page et il se sert de ces liens afin d’améliorer les résultats d’une recherche. Jusqu’en 2016, l’utilisateur pouvait consulter une zone PageRank dans le fureteur et pouvait ainsi connaître sa position dans l’écosystème du web. Depuis, il n’est plus possible de connaître exactement le rang d’une page selon PageRank.

Fonction

Selon la structure

Afin d’évaluer la valeur d’une page, Google analyse certains éléments. Parmi ceux-ci, les liens entrants et sortants, les ancres, le trafic associé à la page, le comportement des utilisateurs et d’autre information comme le nom du domaine. L’algorithme génère une carte de relation entre les différentes pages du web afin de générer un résultat non seulement pertinent, mais rapide. La mesure d’une page web en fonction de ses liens est une façon objective d’évaluer la pertinence d’une page. Ces liens comprennent autant les liens entrant et sortant d’une page ainsi que des mots clés utilisés dans la composition du lien et dans le balisage d’une page HTML. Le texte dans les liens est aussi mis en relation avec la page du lien et la page ou il pointe. L’analyse de la structure des liens entre les pages permet à Google d’évaluer la qualité d’une page et de sa proximité au sujet de recherche.

L'algorithme

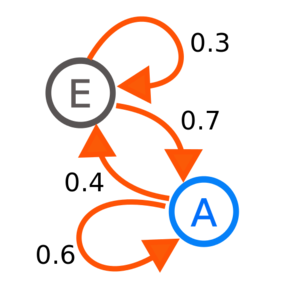

Plus précisément, l’algorithme fonctionne selon un calcul situant une page dans un graphique orienté. De base, la valeur d’une page est de .75 et la formule est la suivante:

Simplement, le PageRank de la page A est égale à la somme du rang de la page B, C et D.

Autrement dit, ce sont principalement les liens entrants pointant vers une page qui légitimistes le contenu d'une page en question. Dans le cas ci-dessus, les pages B,C et D pointent exclusivement vers la page A lui donnant ainsi un PageRank (PR) de .75 (.25+.25+.25). Dans le cas échéant ou une page renvoie à plus d’une page (soi-disant que la page B renvoie à la page A et C), la valeur PageRank de la page B est divisée par le nombre de liens sortant.

- PR(A)=(PR(B)/2)+(PR(C)/1)+(PR(D)/3)

Dans la formule ci-dessus, la page B renvoie à la page A et B, la page C à la page A seulement et la page D renvoie à la page A, B et C donnant ainsi un PageRank de .458 à la page A.

Poursuivant, l’algorithme de PageRank prévoit aussi le comportement de l’utilisateur et peut proposer de nouvelles pages selon la position relative de la page sur le web. Ce n’est pas un secret que le lecteur ne lit pas entièrement une page lors de sa navigation. Il avance à l’aide d’hyperliens suggérés dans le texte et peut parfois poursuivre jusqu’à une page qui ne contient pas de lien. Il entreprend donc une nouvelle recherche. De plus, même si le rang d’une page est supérieur à une autre, il se peut que l’utilisateur sélectionne un autre lien parfois aléatoire. Afin de prévoir ce comportement, Google utilise une forme d'amortissement (d) représenté sur une échelle de 0 à 1. De pratique, l’amortissement est fixé à .85 et est calculé en fonction du nombre de pages (n).

- PR=(1-d/n)+d((PR(B)/L(B))+(PR(C)/L(C))+(PR(D)/L(D))[3]

L’amortissement fonctionne selon une chaîne de Markov et pourrait être discuté davantage, mais en ce qui nous concerne, nous voulons souligner l’encadrement de l’utilisateur. Le moteur de recherche propose des liens entièrement subjectif et relatif aux pratiques de lecture du lecteur, les liens qu’il fréquente, du choix de page dans ses recherches et de la proximité des pages fréquentées dans l’écosystème du web.

Problématique

L'édition traditionnelle opère en fonction d'un lectorat humain et elle ne prend pas en considération le lecteur machine. Ce dernier influence autant la visibilité que l'accessibilité du contenu numérique sur le web. Le lecteur est dépendant du moteur de recherche afin de trouver du contenu. La pertinence des liens qu'il fréquente est artificielle, tout en étant indispensable.

Légitimation

Tout ceci soulève plusieurs problèmes. Premièrement, les pratiques d’écriture et de lecture sur le web varient énormément selon la plateforme. Des sites journalistiques aux différents forums de discussions passant par les réseaux sociaux, le lecteur consomme le texte différemment et lui attribue une légitimité variable. Une plateforme comme Reddit ou Facebook n’a pas la même légitimité que CNN ou encore NASA et devrait, techniquement, avoir un rang supérieur lors d’une recherche, mais ce n’est pas toujours le cas. L’algorithme cré des agglomérations de pages web relatives aux termes de recherche et propose des résultats subjectifs. Cette forme de curation était autrefois attribué à la fonction éditoriale. Dans un contexte artistique ou encore récréatif, ceci n’est pas autant problématique que dans un environnement journalistique. L’éditeur pourrait très bien offrir de l’information plus pertinente, mais le lecteur peut rester captif des plateformes qu’il fréquente et du format de l’information qui s’y trouve. Cette désintermédiation est encore plus apparente dans un contexte d'indexation comme Google. Il serait donc facile qu’un lecteur reste captif dans son environnement numérique et qu’il légitimiste le contenu de pages de moindre qualité par simple manque de variété dans ses lectures.

Économie de l'attention

Les pratiques de lecture non linéaire que l’on trouve sur le web diffèrent du livre principalement par son utilisation d’hyperliens. Le lecteur consomme plus rapidement l’information qu’il recherche et ne lit pas entièrement le texte. Il vogue d’une page à une autre, toujours stimulé par une nouvelle lecture ou expérience multimédia. Jumelé à l’écosystème d’agglomération des pages créé par Google, un éditeur cherchant à valoriser son contenu a tout intérêt à créer un texte court, riche en hyperliens et lié de façon à contrôler le parcours de l’utilisateur[4]. Ce changement de paradigme et le mouvement vers l’éditorialisation qu’il provoque caractérisent cette problématique. Autant que la chaîne éditoriale traditionnelle ne fonctionne plus sur le web et le rôle de l’éditeur soit parfois remis en question par l’arrivée du numérique, au contraire, ses fonctions doivent maintenant incorporer la nature organique du web et de ses moteurs de recherche.

Pérennité

Parmi la myriade de pages sur le web, un bon nombre n’est plus compatible[5] avec l’algorithme de Google. PageRank filtre le web et ignore de façon sélective les pages qui ne sont pas plus compatibles avec les pratiques modernes du web. Certes, Google a dû intervenir plusieurs fois afin de rétablir l’ordre suite à un bon nombre de pratiques cherchant à manipuler l’algorithme. Parmi ces itérations, Google Hummingbird[6] mise en ligne en 2013 prend en considération le sens de chaque mot dans la requête afin d’en comprendre le sens. C’est le sense de la requête, prise en entier, qui est priorisé à l’inverse des mots. En 2012, la mise à jour Pirate[7] limite les pages qui contiennent un contenu en conflit avec les nomes DMCA. À chaque itération de l’algorithme, un nombre considérable de pages web peuvent perdre leur rang et d’autres peuvent même être ignorés de façon permanente. La longévité d’une page web est donc étroitement liée au moteur de recherche et il revient à l’éditeur numérique de rétablir la page ou de la laisser périr. À l’inverse du texte papier, un nombre considérable d’écritures numériques disparaît suite aux changements apportés à l’algorithme et souligne la fragilité du format numérique.

Conclusion

Notes et Références

Mille, Alain. « D’Internet au web ». Dans Pratiques de l’édition numérique. Sous la direction de Michael E. Sinatra et Marcello Vitali-Rosati, 7–11. Parcours Numériques. Montréal: Les Presses de l’Université de Montréal, 2014. http://www.parcoursnumeriques-pum.ca/d-internet-au-web.- Aller ↑ http://infolab.stanford.edu/pub/papers/google.pdf

- Aller ↑ https://www.comscore.com/Insights/Press-Releases/2009/12/comScore-Releases-November-2009-U.S.-Search-Engine-Rankings?cs_edgescape_cc=CA

- Aller ↑ http://infolab.stanford.edu/pub/papers/google.pdf

- Aller ↑ Jones, Rodney H.; Hafner, Christoph A. (2012). Understanding Digital Literacies. New York: Routledge. p. 90. ISBN 9780415673167.

- Aller ↑ BOULÉTREAU, Viviane et Benoît HABERT, « Les formats », Pratiques de l’édition numérique, sous la direction de Michael E. Sinatra et Marcello Vitali-Rosati, Montréal: Les Presses de l’Université de Montréal, 2014, Parcours Numériques, p. 145–159, [Disponible en ligne: http://www.parcoursnumeriques-pum.ca/Les-formats http://www.parcoursnumeriques-pum.ca/Les-formats].

- Aller ↑ https://searchengineland.com/library/google/hummingbird-google

- Aller ↑ https://searchengineland.com/library/google/google-pirate-update